Vers le Futur : Révolutionner la Prédiction avec les Régressions Linéaires et Polynomiales

Démystifier la Régression Linéaire et Polynomiale : Comprendre les Fondamentaux et Applications

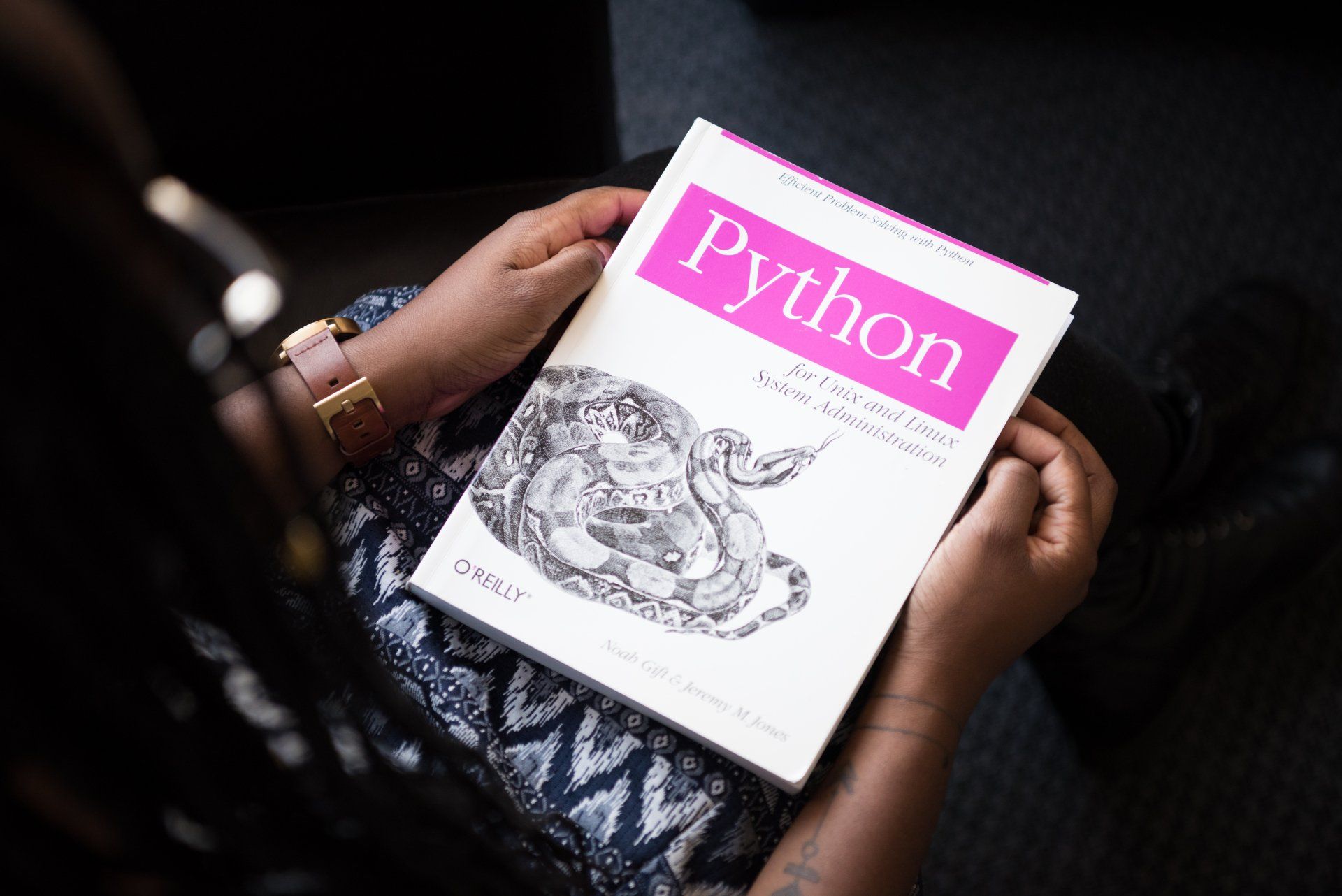

L'intelligence artificielle (IA) et l'apprentissage automatique (Machine Learning, ML) ont révolutionné de nombreux domaines, allant de la reconnaissance vocale aux systèmes de recommandation, en passant par le diagnostic médical. Au cœur de ces avancées se trouvent divers types d'algorithmes d'apprentissage et modèles, chacun adapté à des types spécifiques de problèmes et de données. Cet article explore les principaux types d'algorithmes d'apprentissage automatique et leurs applications.

Apprentissage Supervisé

L'apprentissage supervisé est probablement le type d'apprentissage automatique le plus répandu. Dans ce cadre, l'algorithme apprend à partir d'un ensemble de données étiquetées, essayant de prévoir l'étiquette pour de nouvelles données. Les principaux types de modèles dans l'apprentissage supervisé incluent :

- La Régression (linéaire, polynomiale) : utilisée pour prédire des valeurs continues, comme le prix d'une maison ou la température d'une journée.

- La Classification (logistique, arbres de décision, forêts aléatoires, machines à vecteurs de support) : utilisée pour prédire des catégories discrètes, comme si un email est un spam ou non.

Apprentissage Non Supervisé

Contrairement à l'apprentissage supervisé, l'apprentissage non supervisé travaille avec des données non étiquetées. L'objectif est de découvrir des motifs ou des structures cachées dans les données. Les techniques courantes incluent :

- Le Clustering (K-means, clustering hiérarchique) : utilisé pour regrouper des ensembles de données en clusters basés sur leur similarité.

- La Réduction de Dimensionnalité (analyse en composantes principales, t-SNE) : utilisée pour réduire le nombre de variables tout en conservant l'essentiel de l'information.

Apprentissage Par Renforcement

L'apprentissage par renforcement est une approche où un agent apprend à effectuer des actions dans un environnement de manière à maximiser une certaine notion de récompense cumulative. Les algorithmes de Q-learning et les réseaux de neurones à politique profonde (DNN) sont des exemples de cette catégorie.

Réseaux de Neurones et Apprentissage Profond

Les réseaux de neurones artificiels, en particulier les modèles d'apprentissage profond, ont conduit à des percées significatives dans des domaines tels que la vision par ordinateur et le traitement naturel du langage. Ces modèles peuvent apprendre des représentations de données complexes à travers de multiples couches, permettant ainsi de résoudre des tâches qui étaient auparavant jugées difficiles pour les machines.

- Les Réseaux de Neurones Convolutionnels (CNN) : excellents pour les tâches de vision par ordinateur comme la classification d'images.

- Les Réseaux de Neurones Récurrents (RNN) et les Transformers : performants pour les tâches de traitement du langage naturel, comme la traduction automatique.

La Régression Linéaire

La régression linéaire est l'un des modèles statistiques les plus fondamentaux et les plus utilisés pour analyser la relation entre deux variables ou plus. L'objectif de la régression linéaire est de modéliser la relation linéaire entre une variable dépendante (Y) et une ou plusieurs variables indépendantes (X). Voici comment elle fonctionne :

Régression Linéaire Simple

La régression linéaire simple modélise la relation entre une variable dépendante Y et une variable indépendante X à l'aide d'une ligne droite. Cette ligne peut être décrite par l'équation suivante :

Y=β0 +β1X+ϵ

- Y est la variable dépendante (par exemple, le prix d'une maison).

- X est la variable indépendante (par exemple, la superficie de la maison).

- β0 est l'ordonnée à l'origine de la ligne, c'est-à-dire la valeur de Y lorsque X=0.

- β1 est la pente de la ligne, c'est-à-dire le changement dans Y pour un changement d'une unité dans X.

- ϵ est le terme d'erreur qui représente la différence entre les valeurs observées et les valeurs prédites par le modèle.

Régression Linéaire Multiple

La régression linéaire multiple étend le modèle simple pour inclure plusieurs variables indépendantes. Elle est utile pour examiner comment plusieurs facteurs influencent une variable dépendante. L'équation pour la régression linéaire multiple est :

Y=β0 +β1X1+β2X2+...+βnXn+ϵ

- Chaque Xi représente une variable indépendante différente.

- Les βi sont les coefficients qui mesurent l'impact de chaque variable indépendante sur la variable dépendante.

Les coefficients de la régression linéaire sont généralement estimés en utilisant la méthode des moindres carrés. Cette méthode cherche à minimiser la somme des carrés des écarts (ϵ^2) entre les valeurs observées de Y et les valeurs prédites par le modèle linéaire. Les solutions aux équations des moindres carrés donnent les estimations des coefficients qui définissent la ligne de régression.

La régression linéaire est largement utilisée dans divers domaines pour :

- Prédire des valeurs (par exemple, prédire le prix des maisons à partir de leurs caractéristiques).

- Évaluer l'importance des variables (par exemple, quelle caractéristique de la maison affecte le plus son prix).

- Tester des hypothèses scientifiques sur les relations entre variables.

Avantages :

- Simplicité et interprétabilité.

- Efficacité computationnelle.

Limitations :

- Suppose une relation linéaire entre les variables indépendantes et la variable dépendante.

- Sensible aux valeurs aberrantes.

- Ne peut pas modéliser des relations complexes sans transformation des variables.

La Régression Polynomiale

La régression polynomiale est une forme d'analyse de régression dans laquelle la relation entre la variable indépendante X et la variable dépendante Y est modélisée comme un polynôme de degré n. Contrairement à la régression linéaire, qui modélise une relation linéaire directe entre les variables, la régression polynomiale est capable de modéliser des relations non linéaires en introduisant des termes polynomiaux.

L'équation d'un modèle de régression polynomiale de degré n peut être exprimée comme suit :

Y=β0+β1X+β2X2+β3X3+...+βnXn+ϵ

- Y est la variable dépendante que l'on cherche à prédire.

- X est la variable indépendante.

- β0,β1,...,βnsont les coefficients du modèle, où β0 est l'ordonnée à l'origine et les autres β représentent l'effet de X à différentes puissances sur Y.

- X^2, X^3,...,X^n sont les termes polynomiaux qui permettent de modéliser la non-linéarité.

- ϵ est le terme d'erreur, représentant la différence entre les valeurs observées et les valeurs prédites par le modèle.

Comme pour la régression linéaire, les coefficients de la régression polynomiale sont généralement estimés en utilisant la méthode des moindres carrés, qui vise à minimiser la somme des carrés des écarts entre les valeurs observées et les valeurs prédites par le modèle.

La régression polynomiale est utile dans des situations où la relation entre les variables indépendantes et dépendantes est curviligne. Par exemple, elle peut être utilisée pour modéliser la croissance des plantes en fonction du temps, la variation des prix du marché en fonction de la demande, ou tout autre phénomène où la relation n'est pas strictement linéaire.

Le choix du degré du polynôme (n) est crucial pour le modèle de régression polynomiale. Un degré trop faible peut ne pas capturer toute la complexité des données (sous-ajustement), tandis qu'un degré trop élevé peut conduire à un modèle trop complexe qui capture le bruit des données plutôt que la relation sous-jacente (surajustement). Le choix optimal de n peut être guidé par des critères statistiques tels que le critère d'information d'Akaike (AIC) ou le critère d'information bayésien (BIC), ou par validation croisée.

Avantages :

- Flexibilité pour modéliser des relations non linéaires entre les variables.

- Utilise les techniques d'estimation bien établies de la régression linéaire.

Limitations :

- Risque de surajustement avec des degrés polynomiaux élevés.

- La sélection du degré du polynôme peut être non intuitive et nécessite une validation soignée.

- Les modèles de degré élevé peuvent être sensibles aux variations dans les données, menant à une instabilité des prédictions.